AI 기술이 빠르게 발전하면서, GPU와 TPU는 인공지능 연산의 핵심 하드웨어로 자리 잡고 있습니다. 하지만 두 장비는 목적과 구조, 성능이 크게 다르기 때문에 상황에 따라 적절한 선택이 중요합니다.

이 글에서는 GPU vs TPU의 차이, 성능 비교, 어떤 상황에서 무엇을 선택해야 하는지를 가장 쉽게 이해할 수 있도록 정리했습니다.

1. GPU와 TPU의 기본 차이

✔ GPU(그래픽 처리 장치)

GPU는 원래 게임·그래픽 렌더링을 위해 만들어진 칩이지만,

수천 개의 코어로 병렬 연산을 수행할 수 있어 딥러닝에도 적합합니다.

- 제조사: NVIDIA, AMD

- 특징: 범용성 높음, 모델 훈련부터 추론까지 모두 활용

- 장점: 프레임워크 호환성 최고(PyTorch, TensorFlow, JAX 등)

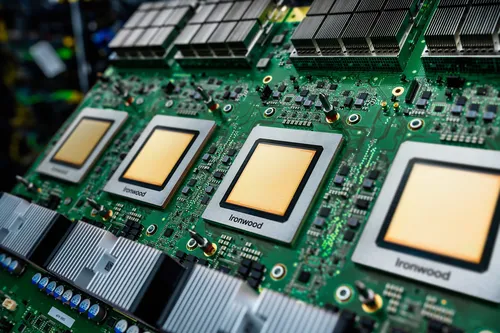

✔ TPU(텐서 처리 장치)

TPU는 Google이 AI 연산 전용으로 설계한 가속 칩입니다.

특히 행렬 곱셈(매트릭스 연산) 속도가 GPU보다 훨씬 빠름.

- 제조사: Google

- 특징: 딥러닝 전용, TensorFlow와 최적화

- 장점: 대규모 모델 학습 시 속도와 효율 압도적

2. 구조적 차이: 왜 TPU가 빠를까?

🔸 GPU

- 수천 개의 코어가 다양한 연산을 처리

- 범용 목적의 연산 가능

- 이미지 처리·AI·영상·과학 연산 등 폭넓은 활용

🔸 TPU

- **MXU(Matrix Multiply Unit)**라는 거대한 행렬 연산 전용 유닛 탑재

- 딥러닝에서 가장 많이 쓰이는 연산(행렬 곱셈)을 극대화

- 명령 처리 프로세스도 AI 모델 학습에 맞춰 단순화 → 오버헤드 낮음

📌 정리:

TPU는 오직 AI 연산만 위해 만들어진 특화 칩 → 효율 극대화

GPU는 다양한 작업이 가능한 범용 칩 → 유연성 + 생태계 강점

3. 성능 비교: GPU vs TPU

⚡ 속도

- TPU는 특히 대규모 모델(예: GPT, Vision Transformer) 학습에서 GPU보다 최대 수 배 빠른 속도를 낼 수 있음

- 작은 모델이나 복잡한 커스텀 연산은 GPU가 더 유리

⚡ 전력 효율

- TPU는 데이터센터용으로 설계되어 **전력 대비 성능(Watt Efficiency)**이 매우 높음

- 대규모 클러스터에서는 TPU가 비용 효율도 더 좋음

⚡ 비용

| 항목 | GPU | TPU |

|---|---|---|

| 초기 비용 | 다양(저렴~고가) | 없음(클라우드 기반) |

| 클라우드 비용 | 비교적 높음 | 동일 성능 기준 더 저렴한 경우 많음 |

| 대규모 학습 | 효율 떨어질 수 있음 | 매우 효율적 |

4. 어떤 상황에서 무엇을 선택해야 할까?

✅ GPU를 선택해야 하는 경우

- PyTorch 중심의 모델 개발

- 다양한 알고리즘 테스트 및 실험

- 개인 개발자·연구자

- 이미지/영상 처리, 시각화, 3D 등 멀티목적 사용

✅ TPU를 선택해야 하는 경우

- TensorFlow 기반 대규모 모델 학습

- 대규모 클러스터 기반 학습(Large Scale Training)

- LLM·Vision Transformer 등 고밀도 행렬 연산 중심 모델

- 비용 대비 성능 최적화를 원할 때

5. 실제 사용 사례

🌐 GPU

- NVIDIA CUDA 생태계

- 자율주행, 영상처리, 게임 엔진, 로보틱스

- AI 스타트업·연구기관에서 폭넓게 사용

🌐 TPU

- Google 검색 엔진·YouTube 추천

- Gmail 스팸 필터

- 구글 포토 이미지 분석

- 구글 내부 대규모 AI 모델 학습

6. 결론: GPU vs TPU 중 무엇이 더 좋은가?

두 하드웨어는 서로의 경쟁자라기보다 목적이 다른 도구입니다.

- 유연성과 생태계 → GPU

- 대규모 AI 학습 속도·효율 → TPU

딥러닝을 처음 시작한다면 GPU가 더 적합하며,

대형 모델이나 엔터프라이즈 환경에서는 TPU가 압도적인 효율을 제공합니다.

✔ 최적의 선택은 사용 목적 + 모델 구조 + 프레임워크에 따라 달라집니다.